本文转自:人民邮电报

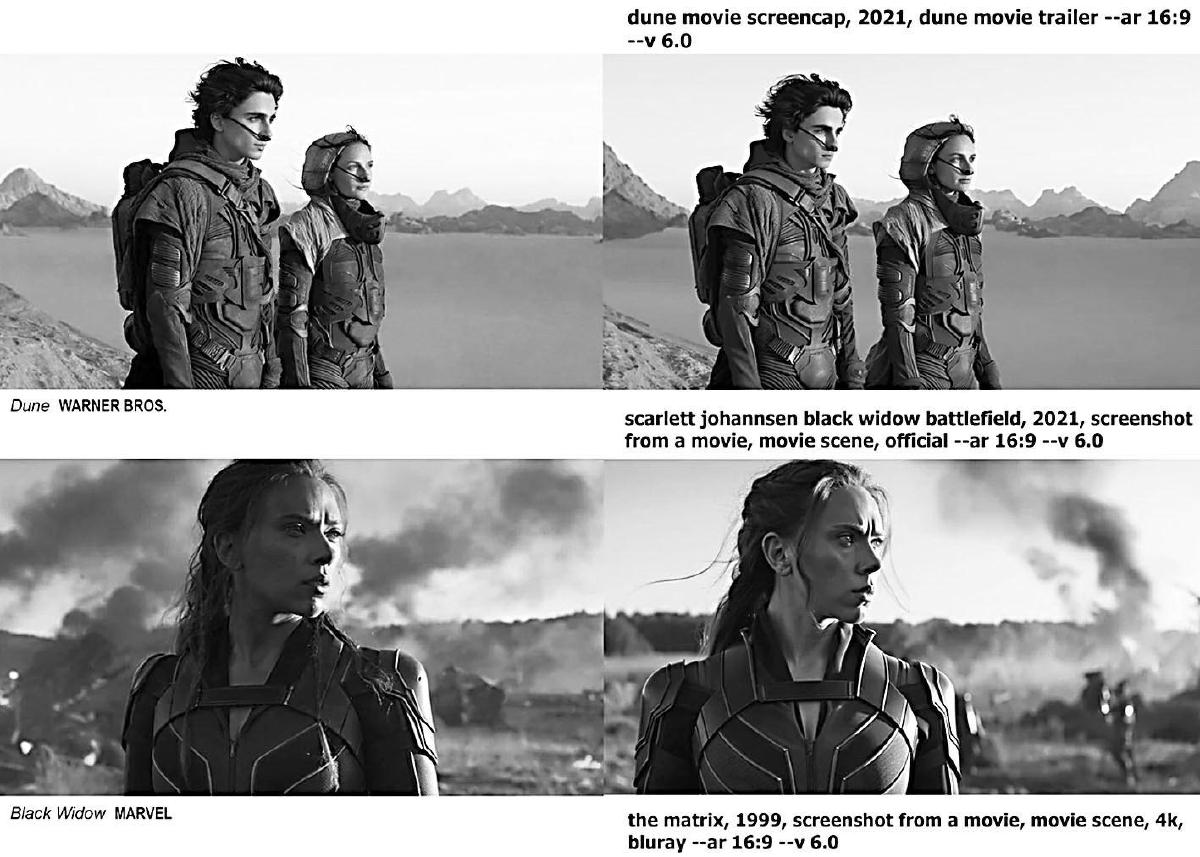

Midjourney制作的图像与知名电影和视频游戏中的镜头几乎相同(左侧为原作,右侧为Midjourney生成图片)。

(图片来源:IEEE Spectrum)

这些图像均由Midjourney制作生成,提示词中均包含“screencap”。

(图片来源:IEEE Spectrum)

大语言模型(LLM)在多大程度上“记住”了其训练输入内容是一直以来广受关注的问题。而最近的实证研究表明,大语言模型在某些情况下的确可以重现或者生成只包含细小差别的训练集内初始文本。

例如,Milad Nasr及其同事在2023年发表的一篇论文表明,大语言模型可能会在提示词的引导下泄露个人信息,比如电子邮箱地址和电话号码等。来自谷歌Deepmind的Nicholas Carlini也在最近的研究中发现,参数规模较大的大语言模型有时会逐字逐句照搬训练时“见过”的大段文本。

前不久,《纽约时报》向美国曼哈顿联邦法院提起诉讼,指控OpenAI涉嫌违规使用其内容用于人工智能开发的事件引起了社区极大的关注与讨论。《纽约时报》称其“非法使用”“数百万篇”受版权保护的文章来训练生成式人工智能模型,并要求赔偿“数十亿美元”。

对此,OpenAI知识产权和内容首席Tom Rubin表示,公司近期与数十家出版商展开了有关许可协议的谈判:“我们正处于多场谈判中,正在与多家出版商进行讨论。他们十分活跃积极,这些谈判进展良好。”

自生成式AI应用成为热门话题以来,版权问题逐渐凸显。我们把复制训练数据的输出称为“抄袭输出”。此类输出的存在和特定诉讼结果很可能决定生成式AI的未来经济效益和社会影响。

如何判定LLM的输出内容是否属于对训练内容的抄袭?这是一个难以精确回答的问题。其中一个原因是LLM就像一个“黑盒子”——我们并不完全了解输入(训练数据)和输出之间的关系。更重要的是,大语言模型的输出可能从此刻到下一刻发生难以预测的变化,且抄袭输出的程度可能由模型大小和训练集的具体性质决定。也正是由于LLM的这种“黑盒子”特性(对于开发者自己也是如此,无论是否开源),关于抄袭输出的问题只能通过实验的方式来研究解决。

值得注意的是,由于抄袭输出的存在,引发了一系列问题,包括技术问题(可以采取哪些措施来避免抄袭输出)、社会学问题(新闻业会因此受到哪些影响)、法律问题(这些输出是否涉及版权侵犯)以及实际问题(当用户使用LLM生成的某些内容时,是否需要担心版权问题)。

抄袭输出是否仅存在于文字生成领域,文生图模型是否也会基于受版权保护的图片产生抄袭输出?

从Midjourney v6“alpha”版摘录的部分示例表明,只要提供与商业电影相关的简短提示词,Midjourney的最新版本就会生成和原作高度相似的抄袭输出。(见下图左)

如果提示词中不包含电影名称、角色、演员等信息,Midjourney应该不会产生抄袭输出吧?经过多番尝试,测试人员最终发现,在提示词包含“screencap(截图)”时,即使没有输入任何电影/游戏的角色信息,也会生成明显的侵权内容。(见下图右)

测试人员认为,目前的实验结果表明,Midjourney存在违规使用受版权保护的素材的行为,从而引发抄袭输出的问题。即使提示词中没有要求模型生成侵权内容,用户仍然可能面临版权侵权索赔的风险。这一发现并非偶然,事实上,Midjourney最近已经因为类似的问题陷入法律纠纷。Midjourney最近收到了4700多名艺术家的联合起诉,因为Midjourney在未经同意的情况下使用了他们的作品用于训练AI。

目前尚不清楚Midjourney的训练数据中包含多少未经许可使用的版权材料,该公司对于其原始训练数据以及哪些数据获得了相应使用许可都尚未公开。如果未获得原素材许可,可能会使Midjourney面临来自电影工作室、视频游戏发行商、演员等的大量诉讼。

与Midjourney一样,OpenAI的文生图大模型DALL·E 3似乎也借鉴了大量受版权保护的素材,即使提示词中没有要求模型生成侵权内容,DALL·E 3仍能够创建与原作高度相似的复制品。

解决生成式AI大模型的抄袭输出问题有多难?从训练数据集的角度来看,如果发现有受版权保护的材料被用于训练,就需要从数据集中删除这些材料。然而,不同于在数据库中简单地删除某项数据,从训练数据集中删除特定受版权保护的材料并不仅仅是简单地移除数据。由于AI大模型的训练依赖于大规模的数据集,删除部分数据集可能需要对模型进行重新训练,以确保模型的准确性和有效性,而这一过程需要消耗大量的时间和计算资源。此外,大模型在生成内容时往往会借鉴和参考已有的知识,这使得判断其输出是否侵犯版权变得更加复杂。

然而,尽管解决抄袭输出问题并不容易,但一些方法和策略仍然值得尝试。首先,开发者可以通过改进模型的训练方法和算法,使其更加注重原创性和多样性。这可以通过引入更加先进的生成模型、使用更加全面的数据集或者改进模型的优化目标来实现。

其次,引入版权保护机制也是一种有效的方法。这种机制可以在AI生成内容时自动检测和防止抄袭,从而确保其输出的合法性和道德性。这可能需要开发专门的技术和工具,以实现对互联网上信息的实时监控和检测。

最后,用户在使用生成式AI时也需要提高自身的版权意识。用户应该尊重原创者的知识产权,在使用AI生成的内容时注明来源和版权信息。同时,用户也应对AI的输出进行合理的评估和审查,避免使用AI生成的侵权内容。

(Gary Marcus & Reid Southen/文吴双/译)

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏

发表评论

评论列表(0)